La Revolución del Desarrollo Ultrarrápido

Este post no pretende defender ni criticar la metodología Vibe Coding. Solo busca compartir una experiencia real aplicándola para liquidar una deuda técnica crítica en nuestra startup. Dentro del equipo de VAIS existen opiniones divididas sobre Vibe Coding, pero todos coincidimos en algo: cuando se usa bajo un marco de ingeniería riguroso, el resultado es asombroso.

Hecho Crítico: Logramos la migración completa de nuestra landing page bajo un paradigma de desarrollo asistido por IA, en una sola jornada (menos de 24 horas), con un squad de solo dos ingenieros y un stack de agentes distribuidos.

El Problema: Costo de Oportunidad y Deuda Técnica

Nuestra landing arrastraba una deuda técnica y un gap de diseño acumulado hacía meses. El problema no era técnico, sino de costo de oportunidad. El refactor o la migración siempre competía contra el roadmap del core business.

La estimación inicial para un squad tradicional era de 4 a 6 semanas. Esta métrica hizo inviable priorizarla con recursos internos, permitiendo que la deuda creciera como una barrera para el crecimiento comercial.

Nuestra Solución: Aplicar Vibe Coding bajo un Marco Sólido

La aplicación de Vibe Coding fue viable porque ya contábamos con activos esenciales:

- Base Funcional: Una landing existente que servía como fuente de verdad y contexto.

- Requerimientos Claros: Historias de usuario vigentes y criterios de aceptación definidos.

- Activos de Diseño: Un Design System, un Template Manager y un Manual de Marca listos para inyección de contexto.

- Ecosistema de IA: Ya teníamos un stack de agentes inteligentes pre-entrenados para tool-use en nuestro workflow.

Nuestra experiencia nos dictó una máxima de ingeniería: si quieres usar IA de forma efectiva, la regla divide y conquistarás se traduce en el Patrón de Agente de Responsabilidad Única (S.R.A.P. - Single Responsibility Agent Pattern).

Atomizamos la migración en microobjetivos, reduciendo drásticamente el contexto necesario y mejorando el output al mitigar la alucinación de los agentes.

1. Capa de Desarrollo Humano Supervisada (HITL)

Todo el flujo estuvo gobernado por un ingeniero en el rol de AI Tech Pilot, bajo el principio HITL (Human In The Loop). El humano no codificó, sino que actuó como Arquitecto y Auditor del Proceso.

Sus responsabilidades críticas fueron:

- Gobernanza de Código: Auditoría de merge requests y aprobación final de Pull Requests (PR) generados por agentes.

- Validación de NFRs: Control manual de accesibilidad (WCAG), rendimiento y consistencia de UI/UX.

- Ingeniería de Contexto: Optimización iterativa del prompt y el contexto inyectado para refinar el output.

- Resolución de Ambigüedades: Intervención en corner cases no resueltos por el feedback loop automático.

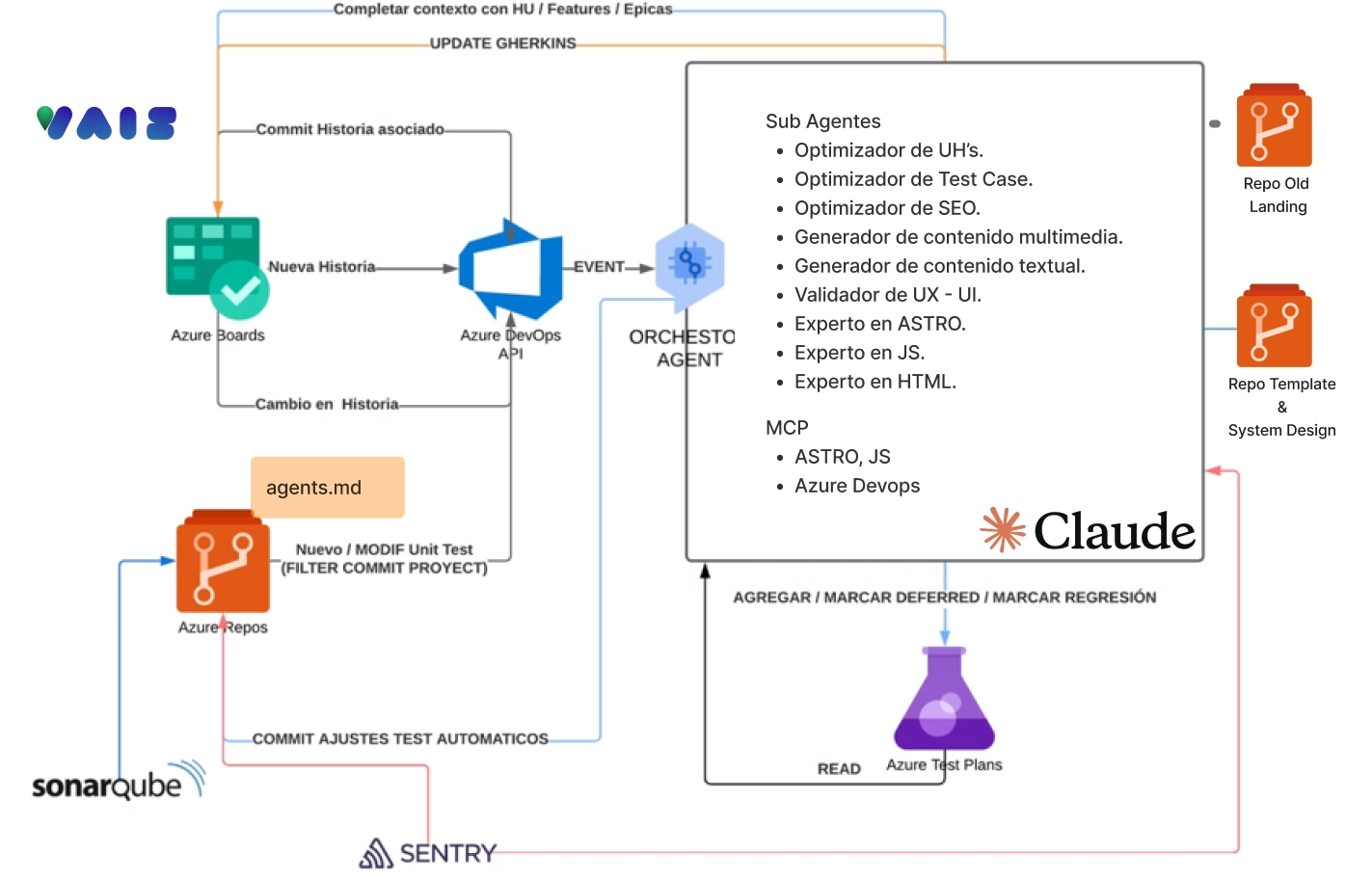

2. Capa de Agentes Inteligentes Distribuidos

La arquitectura implementó un Agente Orquestador Central (Controller Agent), encargado de: (1) Descomponer el backlog, (2) Definir el flujo de ejecución, y (3) Delegar la tarea con su contexto limitado al Agente Especializado (Worker Agent).

Este modelo distribuye la complejidad y se adhiere al S.R.A.P.

| Agente | Función | Output / Artefacto |

|---|---|---|

| Story Refiner | Refina HU y mapea criterios de aceptación al DoC (Definition of Code) | HU listas para inyección en el prompt |

| Component Generator | Construye componentes con framework específico (ej: Astro) | Componentes .astro / .ts / Styles |

| Content Optimizer | Redacción UX, SEO on-page y micro-copy | Payload de texto optimizado |

| NFR Validator | Ejecuta heurísticas de usabilidad y consistencia de Design System | Reporte de suggestions / Solicitud de refactor |

| SEO Tech Agent | Metadatos (schema markup), estructura (A11Y), Core Web Vitals | Optimización de tags y HTML semántico |

| Testing Generator | Genera Unit Tests e Integration Tests | Archivos .spec.ts / .test.ts con cobertura |

| Refactor & QA Agent | Aplica convenciones, linter fixes, y optimización de runtime | PR listo para la capa de GIT (GitHub/GitLab) |

| Deployment Handler | Ejecuta la pipeline de CI/CD (Test & Deploy) | Despliegue en staging / production |

Cada Worker Agent producía entregables verificables. En caso de no cumplir con los criterios (ej: fallar los tests), el flujo entraba en un feedback loop iterativo con corrección automática hasta alcanzar el Definition of Done.

Ningún agente trabaja solo. Siempre existe un desarrollador supervisando, ajustando y guiando. Los agentes aceleran, no reemplazan criterio.

¿El resultado? Time-to-Value Acelerado

Fue satisfactorio. Con una buena planificación, segregación de tareas, un piloto humano atento y la selección correcta de modelos, logramos migrar la landing sin frenar al equipo ni desviar foco de nuestras prioridades estratégicas.

Y lo más interesante no fue la velocidad, sino el cambio cultural que activó en equipo…

(esto lo podríamos desarrollar en la próxima parte 😉)